Het olifantje en zijn data honger..

Nu internet een steeds centralere rol gaat spelen in ons leven en er steeds meer dingen aan internet aangesloten worden, levert dit gigantische hoeveelheden data op. Hierbij zien we steeds meer zaken als sensoren en gps locaties (bijvoorbeeld bij een tweet) in de internet ‘cloud’ beschikbaar komen.

De afgelopen jaren kende we al een explosieve data groei in informatie die door eind gebruikers werd gegenereerd uit websites, ‘homepages’ en later blogs en wiki’s. Marissa Mayer (VP for Search Products bij Google) geeft aan een vijf tienvoudige (!) groei te zien in beschikbare data op internet t.o.v. van 3 jaar geleden.

Binnen IT enterprise omgevingen worstelt men ook al tijden met een data en informatie explosie. Binnen de meeste organisaties zijn tientallen informatie systemen beschikbaar die vaak niet gekoppeld of generiek doorzoekbaar zijn. Men probeert deze informatie te beteugelen door er een datawarehouse , enterprise search en business intelligence (BI) tegen aan te gooien. Deze systemen hanteren meestal een relationele database waar bij men probeert informatie uit diverse bronnen naar binnen te trekken. Hierna kan er analyse en rapportage plaats vinden op deze verzamelde informatie. Feitelijk probeert men 1 grote informatie bak te creëren.

Enterpise IT wil echter ook graag gebruik gaan maken van de informatie die op internet beschikbaar is en daar via diverse bronnen word aangeboden. Analyse op deze data kan het bedrijf een competitief voordeel opleveren;

One big area could be social media analytics: When I was in Armonk in August, IBM VP of Emerging Technologies Rod Smith indicated that the appetite for social media analytics is “huge,” citing one BigInsights customer that is analyzing more than a terabyte of Twitter data per day and maintaining a 30-day archive.

Deze informatie hoeveelheden wil je niet binnen je datawarehouse omgeving trekken; het eindeloos RDBMS systemen er tegen aan gooien levert op den duur een onbetaalbare omgeving op. Zoals database guru Guy Harrison recent melde:

We’ve seen the trend of the size of the largest enterprise databases, growing steadily and exponentially, and data warehouse technology, by and large until relatively recently, kept up with that. The exponential growth has just outstripped what can be done even by the largest databases now. Oracle and Teradata are struggling, but Hadoop’s come along and provided an alternative that’s more economical.

Right at this second, there’s not a lot of our customers who are likely to adopt NoSQL, but there’s a lot of people who will, over the next year or so, adopt Hadoop. The economics for processing large amounts of log data or creating massive data warehouses on Hadoop are cost-effective compared to Oracle’s Exadata.

Hadoop?

Hier komt de ontwikkeling van Hadoop in beeld. Deze verzameling van opensource producten komt voor een groot deel uit de koker van Google, die  in 2003 steeds meer moeite had om de groeiende hoeveelheden data op het web te kunnen indexeren en doorzoeken. Ook het analyseren van de index informatie werd steeds lastiger waardoor de kwaliteit van de zoek resultaten achteruit liepen. Om dit probleem te adresseren ontwikkelde enkele Google engineers MapReduce, die samen met Google’s eigen file management technologie voor een oplossing zorgde.

in 2003 steeds meer moeite had om de groeiende hoeveelheden data op het web te kunnen indexeren en doorzoeken. Ook het analyseren van de index informatie werd steeds lastiger waardoor de kwaliteit van de zoek resultaten achteruit liepen. Om dit probleem te adresseren ontwikkelde enkele Google engineers MapReduce, die samen met Google’s eigen file management technologie voor een oplossing zorgde.

Google heeft de details van MapReduce nooit vrijgegeven, maar heeft wel enkele conceptuele documenten uitgebracht rond deze ontwikkeling. De informatie daar in was voldoende voor Doug Cutting om een eigen ontwikkeling te starten genaamd Hadoop. De echte door ontwikkeling kwam toen Doug Cutting werd ingehuurd door Yahoo, waar binnen 6 maanden Hadoop een van de belangrijkste onderdelen vormde binnen de Yahoo infrastructuur.

De gebruikers lijst van Hadoop is lang en bevat enkele van de grootste informatie verwerkers van deze wereld zoals Yahoo, eBay en Facebook. Deze bedrijven zijn ook volop betrokken in het door ontwikkelen van de Hadoop technologie.

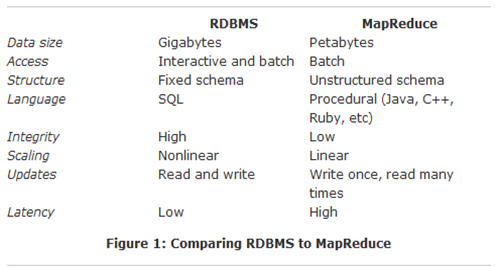

Hadoop =! RDBMS

Hadoop is geen volledige vervanging van de database. Het verwerken van de data in Hadoop kost iets meer tijd, van twee minuten tot twee uur. Dit is aanzienlijk trager dan in de nu beschikbare database technologie. Hadoop kan dus niet wat een database kan, maar de database is weer veel minder schaalbaar.

Voor de analyse op Hadoop is inmiddels een speciale taal ontwikkeld, Hive, die veel lijkt op SQL. Analysten kunnen daarmee vrij snel aan de slag als ze SQL gewend zijn. Voor ontwikkelaars is Pig gemaakt, dat erg lijkt op Python. Door Hive en Pig kan er makkelijk worden gewerkt met Hadoop. Je kunt met Hadoop ook veel beter kijken naar grote hoeveelheden data en er de eigenaardigheden in isoleren. Zo is het heel geschikt voor analyse van bijvoorbeeld klimaatverandering.

Een voorbeeld van directe inzet van Hadoop in een enterprise IT omgeving, samen met bestaande RDBMS:

Meer over dit voorbeeld op: http://www.ebizq.net/blogs/enterprise/2009/09/10_ways_to_complement_the_ente.php. Deze manier word ook gehanteerd binnen Facebook.

Om de diverse tekortkomingen van Hadoop te compenseren word er op dit moment door diverse grote bedrijven hard ontwikkeld aan oplossingen die geschikt zijn om de technologie binnen enterprise omgevingen te laten landen.

IBM heeft de eerste commerciële toepassingen van Hadoop gelanceerd;

IBM on Wednesday is set to announce a new portfolio of solutions and services to help enterprises analyze large volumes of data. IBM InfoSphere BigInsights is based on Apache Hadoop, an open-source technology designed for analysis of big volumes of data.

IBM InfoSphere BigInsights is made up of a package of Hadoop software and services, BigSheets, a beta product designed to help business professionals extract, annotate, and visually uncover insights from vast amounts of information quickly and easily through a Web browser, and industry-specific frameworks to help clients get started.

Ook het bedrijf Cloudera werkt hard aan de commerciële toepassing van Hadoop.

En zo zien we weer een product uit de ‘Formule 1 van de ICT’ in enterprise IT omgevingen terecht komen.

Het mag duidelijk zijn dat er veel ontwikkelingen gaande zijn rond het verzamelen en analyseren van grote hoeveelheden data en dat dit 1 van de grootste uitdagingen voor de volgende generatie van (enterprise) ICT is. Hadoop kan hier een grote rol in spelen; op dit moment als onderdeel van een bestaand RDBMS concept maar op korte termijn zeker breder dan dat.

ICT techneuten tip: houd deze ontwikkeling in de gaten, zorg voor een POC om ervaring op te doen en (her)evalueer eventuele lopende datawarehouse projecten om te kijken of de inzet van Hadoop meer waarde kan leveren.

Goed om verder te lezen:

- What Hadoop is Not

- Guy Harrison on cloud computing and next-generation databases

- HIVE: Data Warehousing & Analytics on Hadoop – door Facebook

- 10 Ways To Complement the Enterprise RDBMS Using Hadoop

De volgende generatie aangekondigd?!?: