Begin maart 2011 vond het Green Grid Technical Forum plaats in Santa Clara (California, USA). Tijdens dit evenement werd door de kersverse Executive Director Mark Monroe een nieuwe richting voor The Green Grid (TGG) aangekondigd.

De afgelopen jaren is TGG zeer succes vol geweest in creëren van aandacht voor energie efficiëntie. Dit gebeurde o.a. met de door hun ontwikkelde Power Usage Effectiveness (PUE). Dit meetinstrument voor de energie efficiëntie van je datacenter omgeving is inmiddels internationaal geaccepteerd en de meeste kaders voor het vaststellen en gebruik van PUE zijn bepaald.

Mark Monroe kreeg begin 2011 de leiding over The Green Grid. Hij heeft jaren lange ervaring op datacenter gebied en was de laatste jaren actief op het gebied van algemene duurzaamheid voor bijvoorbeeld SUN. Hij is ook geen onbekende voor TGG omdat hij 1 van de mede oprichters is. Zijn brede kennis op het duurzaamheids vlak past perfect bij de nieuwe richting die TGG nu neemt.

Op het EMEA Tech Forum (begin 2011) werd al eerder bekend gemaakt, dat men 2 nieuwe efficiëntie eenheden wilde introduceren:

…; Carbon Usage Effectiveness (CUE) en de Water Usage Effectiveness (WUE), zoals ook aangekondigd in recent persbericht:

The new metrics, called Carbon Usage Effectiveness (CUE) and the upcoming Water Usage Effectiveness (WUE), are joining The Green Grid’s widely-used Power Usage Effectiveness (PUE) metric. All are designed to help IT, facilities, and sustainability organizations across the globe optimize their data centers.

Hier mee werd al duidelijk dat de focus voor TGG verschuift van enkel energie efficiëntie naar de duurzaamheid van het gehele datacenter, waar water verbruik ook een belangrijk deel van uit maakt.

Mark Monroe legt de scope wijziging uit:

[youtube=http://www.youtube.com/watch?v=uwQOON42C_w&w=448&h=252&hd=1]

TGG Data Center Maturity Model

Een goed voorbeeld van deze brede aanpak is het Data Center Maturity Model dat tijdens het Technical Forum officieel gepubliceerd werd. Waar voorheen door TGG vooral gekeken werd naar energie efficiëntie op het facilitaire datacenter niveau, word in dit model gekeken naar alle componenten uit de IT keten.

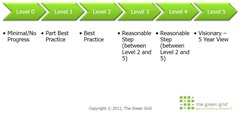

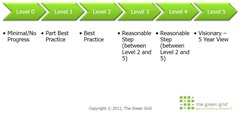

Het model bekijkt facility (met o.a. power, cooling en management) en IT (met compute, storage en network). De volwassenheid op dit vlak kan in kaart gebracht worden op een schaal van 0 (onvolwassen) tot 5 (leading edge). Zodra er bepaald is waar de organisatie staat op deze schaal, kan er een route uitgezet worden naar het volgende niveau. Op deze manier kan het management voor elk vlak een doel uitzetten voor de komende 2 a 3 jaar. Het model geeft daarbij de mogelijkheid om per vlak een score toe te passen. Zo kan een organisatie dus op datacenter cooling een 3 scoren en op IT storage een 2.

The model’s Level 0 means a data center’s maturity is minimal and shows no progress. Level 5 – the highest mark – designates the data center as ‘visionary’.

“The initial levels chart the progress of a typical data center that has taken no efficiency improvement measures to one exemplifying the state of an average data center to one that employs current best practices,” reads the organization’s paper on the model.

Het laagste niveau (Level 0) beslaat een omgeving waar in weinig tot geen aandacht is voor energie efficiëntie. Bij Level 1 en 2 past men de industrie best practices uit. Dit zijn de basis best practices die in geruime maten beschikbaar zijn in de markt op dit moment. Level 5 word bestempeld als visionair. Vanaf Level 3 treffen we technologieën aan die leading edge zijn en volop in ontwikkeling. De gedachte hierbij is dat de markt en technologie over ongeveer 5 jaar de onderdelen uit Level 5 als gemeengoed zou moeten zien. Op deze manier probeert TGG zowel de markt als eind gebruikers te stimuleren gezamenlijk te werken aan nieuwe energie efficiënte oplossingen.

De verwachting is dat state-of-the-art data centers zich zullen ontwikkelen van een Level 2 naar Level 5 rond 2016 (groene lijn) . Een generiek datacenter zal zich ontwikkelen naar Level 3 (gele lijn) en slechter presterende datacentra zullen achter blijven en zich ontwikkelen naar Level 2 (rode lijn).

Het Data Center Maturity Model is uiteraard een levend document waar van op dit moment versie 1 is uitgegeven. Naar mate de technologie en mogelijkheden zich door ontwikkelen, zal ook het model bijgewerkt worden.

Zoals ook destijds bij de PUE ontwikkeling, is het model niet bedoeld als marketing instrument of als vergelijking tussen bedrijven onderling (benchmark). Het model is bedoelt als interne toetsing en handvat voor de interne door ontwikkeling van energie efficiëntie.

Uitgebreide uitleg over het model door Harkeeret Singh (chair of The Green Grid’s EMEA technical committee):

[youtube=http://www.youtube.com/watch?v=1Q8zNjEitS8&w=448&h=252&hd=1]

Het model is hier te vinden. De bijbehorende whitepaper hier.

Datacenter Pulse Summit

Voorafgaand aan het Green Grid Technical Forum organiseerde Datacenter Pulse (DCP) een dag voor hun leden. Dit in het kader van de alliantie tussen Datacenter Pulse en The Green Grid. Tijdens deze bijeenkomst, waar alleen datacenter eigenaren en eindgebruikers welkom waren, werd gekeken naar

de richting die The Green Grid aan het nemen is en werd hier feedback op gegeven. Ook werd er gekeken wat de top 10 zaken zijn die datacenter eigenaren ‘s nachts uit hun slaap houd. De behandelde onderwerpen waren:

- DCP Stack Revision & TGG Maturity Model

- Green Grid Input

- Data Center Design Guide, WUE/CUE Metrics

- The Collision Course of Site Selection and Sustainability

- Modularity, Density, & High-Temp (Combined)

- Gages – Modular DC RFP Process, Modularity readout interest, & Chill Off work

- Operational Challenges: What keeps you up at night?

DCP Stack

De DCP stack is al weer 2 jaar oud en werd onderworpen aan een kritische blik. De huidige versie (2) is bedoelt als referentie model om gespreken binnen organisaties makkelijker te maken en onderlinge relaties en afhankelijkheden te kunnen laten zien. De rechterzijde van het model, dat handelt over duurzaamheid in relatie tot datacenter input (zoals stroom en water) en output, was o.a. de aanleiding voor TGG om te werken aan het Data Center Maturity Model. Deze 2 modellen komen hier mooi samen.

(klik voor groter plaatje)

In het model is ook mooi aan te geven welke ‘convergence’ (versmelting) er op dit moment gaande is in de datacenter en IT industrie. Zo zien we cloud computing, datacenter containers en IT appliances, die allemaal hun druk uitoefenen op de totale IT keten.

Ook werd nogmaals duidelijk dat bij het doorvoeren van duurzaamheids oplossingen, vooral naar de hele keten gekeken moet worden omdat punt oplossingen elkaar negatief kunnen beïnvloeden. Hier over schreef ik ook al eerder.

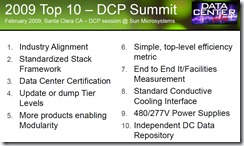

DCP Top 10

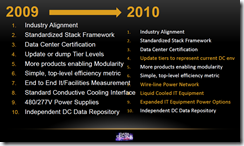

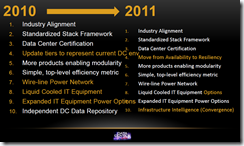

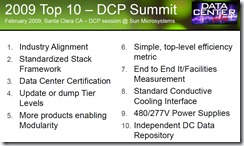

De Top 10 zaken die datacenter eigenaren ‘s nachts uit hun slaap houden werd ook bijgewerkt. Deze werd voor het eerst gepubliceerd in 2009.

Voor 2011 zijn de Top 10 aandachtspunten:

- Industry Alignment

- Standardized Stack Framework

- Data Center Certification

- Move from Availability to Resiliency (new)

- More products enabling modularity

- Simple, top-level efficiency metric

- Wire-line Power Network

- Liquid Cooled IT Equipment Options (new)

- Expanded IT Equipment Power Options

- Infrastructure Intelligence (Convergence) (new)

Datacenter Pulse zal zich uiteraard in 2011 weer inzetten om deze onderwerpen onder het voetlicht te krijgen bij de juiste organisaties en leveranciers en op deze manier het leven van de datacenter eigenaar weer iets makkelijker te maken.

De volledige presentatie van DCP, met alle behandelde onderwerpen, is terug te vinden op TGG website.