Datacenter Pulse Top 10 – 2012

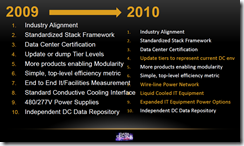

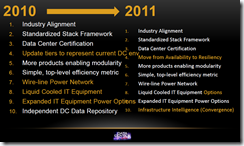

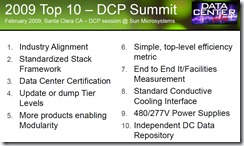

Tijdens de afgelopen Datacenter Pulse Summit 2012, werd de Top10 opnieuw vastgesteld. De Top10’s van de afgelopen jaren (klik voor groter formaat):

Het doel van deze Top10 is de datacenter leveranciers een indruk te geven van de problemen waar datacenter eigenaren (dagelijks) mee worstelen.

De 2012 Top10 bestaat uit de volgende elementen:

1. Facilities and IT Alignment: Al jaren is de kloof tussen facilitair en IT een probleem voor veel bedrijven. De uitdaging is om een gemeenschappelijke taal te ontwikkelen, kosten transparant te maken en technologieën op elkaar te laten aansluiten. Grote bedrijven zoals Microsoft, Google en eBay hebben dit probleem reeds onder controle. In de rest van de ICT sector moet dit zijn beslag nog krijgen.

2. Simple, top-level efficiency metric: Data Center Pulse komt met een voorstel voor een Service Efficiency metriek, welke uitgebreid behandeld is door datacenter eindgebruikers tijdens de afgelopen DCP Summit. Het voorstel bevat een framework die zou moeten werken als een liter-op-kilometer model voor datacentra. Het voorstel word deze zomer uitgewerkt en daarna uitgebracht. Meer info in deze video.

3. Standardized Stack Framework: Al enkele jaren word er gewerkt aan de Data Center Stack. Deze lijkt op het OSI Model, maar dan voor de hele datacenter keten. De 7 lagen in de Stack helpen om de conversatie tussen IT en Facilitair op gang te brengen en relaties tussen onderdelen aan te geven. Versie 2.1 is uit gegeven en word met hulp van andere organisaties zoals Green Grid verder uitgewerkt.

4. Move from Availability to Resiliency: Nu de weerbaarheid applicaties om uitval op te vangen steeds groter word en men beschikbaarheid met geografische spreiding kan oplossen, betekend dit dat men anders kan gaan nadenken over beschikbaarheid in het fysieke datacenter. Het goed uitwerken van deze balans kan kosten verlagen en uiteindelijk beschikbaarheid dramatisch verhogen.

5. Renewable Power Options: Dit is een typisch US probleem; de beschikbaarheid van ‘groene’ stroom mogelijkheden is beperkt in de US. “The lack of cost-effective renewable power is a growing problem for data centers, which use enormous volumes of electricity. Data Center Pulse sees potential for progress in approaches that have worked in Europe, where renewable power is more readily available than in the U.S. These include focusing business development opportunities at the state level, and encouraging alignment between end users, utilities, government and developers.”

6. “Containers” vs. Brick & Mortar: Zijn containers en modulaire ontwerpen realistische optie? Nu steeds meer organisaties hier mee aan de slag gaan, is het belangrijk om hier over de juiste informatie te delen. Een modulair ontwerp dat bij de ene organisatie past, hoeft niet noodzakelijker wijs ook bij de andere. Ook zijn er hybride ontwerpen mogelijk waarbij een bijvoorbeeld een container onderdeel kan uit maken van de bestaande installatie.

7. Hybrid DC Designs: De hybride benadering geld voor modulaire ontwerpen maar ook voor de TIER levels en de redundantie van mechanische en elektrotechnische systemen. Steeds meer datacenter eigenaren besparen geld door het datacenter slim in zones te verdelen waarbij verschillende niveuas van beschikbaarheid mogelijk zijn.

8. Liquid Cooled IT Equipment Options: Voor veel IT operaties is het belangrijk om de hoeveelheid werk per Watt te verhogen. Een hogere densitie (kW) per rack kan hier een positieve rol bij spelen. Hier door komen de limieten van luchtkoeling in beeld en word vloeistofkoeling economisch interessanter. .

9. Free Cooling “Everywhere”: Uit de recente case study van Green Grid over het eBay Project Mercury blijkt dat 100% vrije koeling, het gehele jaar, zelfs mogelijk is in plaatsen als Phoenix (AZ, USA) waar het zomers meer als 45C kan worden. Engineers moeten verder uitgedaagd worden om dit soort opties uit te werken en producten te ontwikkelen die dit ondersteunen.

10. Converged Infrastructure Intelligence: Data center operators moeten hun infrastructuur kunnen benaderen als een geheel systeem. Hierbij dient meting en controle op basis van integratie tussen IT en facilitaire techniek mogelijk te zijn. Datacenter Infrastructure Management (DCIM) is onderdeel van deze trend, maar er is nog veel werk nodig om protocollen en connecties te standaardiseren.

Hier de video met de uitleg van Dean Nelson en zijn blog:

DCP Summit 2012

Dit alles werd samen gesteld op de 2012 Datacenter Pulse Summit vorige week, waar van hier een samenvatting: