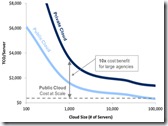

Microsoft heeft recent een onderzoek uitgebracht genaamd The Economics of the Cloud for the EU Public Sector. Dit stuk is inmiddels uitgebreid besproken en bediscussieerd door de ‘cloud guru’s’ van deze wereld. Het stuk focust zich op de economische voordelen van Cloud computing met grof weg de volgende uitkomst:

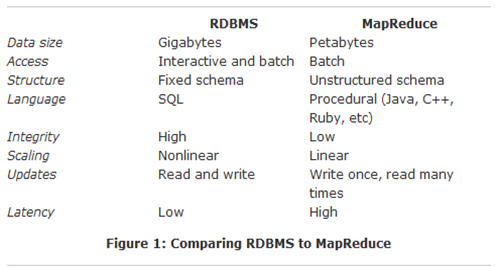

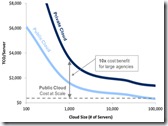

– 80% lagere TCO. De combinatie van IT operatie op grote (massale) schaal, bundelen van gelijksoortige vraag en het bedienen van meerdere gebruikers op 1 omgeving creëren enorme schaalvoordelen in public cloud datacentra; “a 100,000-server datacenter has an 80% lower total cost of ownership (TCO) compared to a 1,000-server datacenter.”

– 40x lagere kosten voor MKB; “For organizations with a very small installed base of servers (<100), private clouds are prohibitively expensive compared to public cloud.”

– 10x lagere kosten voor grote (enterprise) organisaties; “For large agencies with an installed base of approximately 1,000 servers, private clouds are feasible but come with a significant cost premium of about 10 times the cost of a public cloud for the same unit of service.”

Deze uitkomsten zijn niet geheel nieuw. In 2009 werd dit ook al vastgesteld door o.a. AT&T. (zie een oude presentatie daar over). Over de kosten voordelen kan men lang en breed discussiëren, maar op het moment dat echte pay-per-use aan de vergelijking wordt toegevoegd slaat de balans snel uit in het voordeel van public cloud.

Als die kosten voordelen zo groot zijn, waarom stapt men dan nog niet massaal over? Dat antwoord is simpel en ligt in de woorden ‘vertrouwen’ en ‘controle’. Als we kijken naar de adoptie barrières voor public cloud zien we o.a. het volgende:

- Beveiliging

- Volwassenheid (o.a. SLA’s)

- Governance

- Data integriteit

- Monitoring

- Audit

- Identiteit en toegang

- Financiële controls

- Compliance

Al deze bovenstaande redenen voor het niet overstappen, hebben te maken met ‘vertrouwen’ en ‘controle’. Soms is dit vanuit de organisatie zelf (zoals de ‘onvolwassenheid’ van de SLA) en soms vanuit de overheid of andere regulerende instantie (zoals PCI). Deze barrières zullen in de komende jaren steeds meer en meer geslecht worden. Omdat men echter nu al gebruik wil maken van alle geweldige voordelen van cloud, bedachten we iets anders: de private cloud. Wel cloud, maar dan binnen de eigen muur zodat we toch nog controle hebben…

Het Microsoft stuk gaat ook in op de vergelijking tussen private cloud en public cloud;

While private clouds can achieve some degree of cost savings from the scale economies we describe while addressing some governmental concerns about cloud, our analysis reveals there is a price premium associated with private clouds, as the benefits of scale do not apply equally to public clouds and private clouds. Through our analysis, we show that over time the cost of private clouds will increase to be 10x higher than public clouds, while barriers to public cloud adoption will be addressed to a greater degree

Hier is de conclusie dus ook dat de kosten van private cloud hoger uitvallen dan die van public cloud gebruik. Het stuk stelt zelfs de vraag of het bouwen van een private cloud goedkoper is dan outsourcing van bestaande IT… en dat is een interessante gedachte…

Geef me die private cloud!

Rond private cloud bestaat de nodige cloudwash. Dit komt omdat diverse traditionele IT leveranciers zich op de private cloud omgeving hebben gestort als survival strategie en al hun producten als ‘cloud’ bestempelen. Zodra je kiest voor een private cloud word je overspoelt met leveranciers die je kunnen bedienen. In de basis komt het echter op het volgende neer: zelf bouwen of uit de markt halen. Met alle variaties daar tussen.

Als we naar de grote jongens in cloud (Amazon, Google, Microsoft) kijken, zien we dat de echte cloud omgeving is gebouwd op commodity hardware (zoals de Google server) en voornamelijk opensource producten (zoals OpenStack). Dat is voornamelijk een TCO keuze.

Het hebben en beheren van een (private) cloud behelst echter meer. Simon Wardley verwoord dit (zoals altijd) uitstekend:

If you’re building an infrastructure cloud (whether public or private) then I’ll assume you’ve got multi-tenancy, APIs for creating instances, utility billing and you are probably using some form of virtualisation. Now, if this is the case then you’re part of the way there, so go check out your data centre.

IF :-

- your data centre is full of racks or containers each with volumes of highly commoditised servers

- you’ve stripped out almost all physical redundancy because frankly it’s too expensive and only exists because of legacy architectural principles due to the high MTTR for replacement of equipment

- you’re working on the principle of volume operations and provision of standardised “good enough” components with defined sizes of virtual servers

- the environment is heavily automated

- you’re working hard to drive even greater standardisation and cost efficiencies

- you don’t know where applications are running in your data centre and you don’t care.

- you don’t care if a single server dies

… then you’re treating infrastructure like a commodity and you’re running a cloud.

Dit alles maakt het een grote uitdaging voor veel organisaties om een echte private cloud te bouwen. Een logische optie kan zijn om bepaalde bouwblokken uit de markt te halen en toch een deel van de voordelen van private cloud te genieten.

Virtualisatie alleen =! Cloud (, maar het helpt wel)

Voor het bouwen van een private cloud helpt virtualisatie. Dit is niet alleen het geval vanuit technologie oogpunt maar ook vanuit de effecten die virtualisatie met zich mee brengt voor organisatie en proces als transitie naar cloud.

Zoals de whitepaper hier over vermeld:

Virtualisatie is GEEN cloud computing, maar het forceert dezelfde wijzigingen op de organisatie. De technologie wijziging is hierbij misschien zelfs minder belangrijk; het is eigenlijk een cultuur wijziging. Virtualisatie forceert de eindgebruiker bijvoorbeeld om de fysieke implementatie van hun dienst los te laten (‘ik wil dit servertje, merk X’) en te vragen om functionele en service termen en beschrijvingen. Veel organisaties hebben geen duidelijke SLA’s beschreven en hebben in plaats daar van constant interactie met hun interne leveranciers om te zorgen voor de juiste levering en het oplossen van problemen.

Converged Infra =! Cloud (, maar helpt wel)

Converged infrastructuur is een ontwikkeling die helpt bij het kiezen van een private cloud bouwblok. Hierbij zien we de samensmelting tussen diverse hardware en infrastructuur onderdelen zoals servers, netwerk en opslag. Hierbij worden deze door de leverancier geïntegreerd geleverd.

Virtualisatie zorgt voor de ontkoppeling tussen hardware en het besturingssysteem, maar neemt het beheer en onderhoud van de hardware laag niet weg. Converged infrastructuur komt hierbij te hulp door een hoge mate van automatisering door te voeren op deze laag. Denk hierbij aan automatische firmware en bios management bijvoorbeeld.

Diverse leveranciers zoals HP, IBM, Dell en Cisco leveren oplossingen in deze richting. Een goed overzicht hier van is te vinden in een whitepaper door Forrester; Are Converged Infrastructures Good For IT?

Meer bouwblokjes…

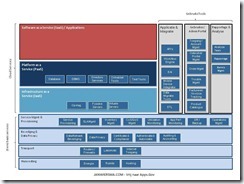

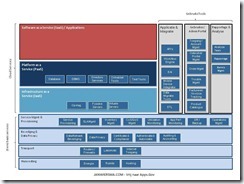

Met virtualisatie en converged infrastuctuur zijn we er nog niet. Zaken zoals self-service websites, catalogussen en API’s zijn ook noodzakelijk om te komen tot een volledige private cloud omgeving. Een voorbeeld van de benodigde blokkendoos:

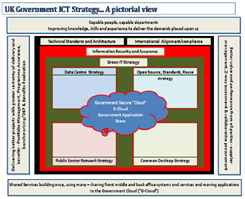

Vrij naar apps.gov (klik voor groter formaat)

Hierbij komen diverse leveranciers je te hulp met hun producten. Zowel uit de opensource hoek als uit de proprietary software hoek zijn er diverse producten beschikbaar. Zie hier voor de whitepaper van Forrester: You’re Not Ready For Internal Cloud

Al deze bovenstaande onderdelen leveren uiteindelijk een private cloud omgeving op de Infrastructure As A Service (IAAS) laag in je eigen datacenter. Op deze lAAS laag zijn nu diverse volwassen oplossingen op de markt.

Dit brengt ons bij de volgende stap in de cloud laag; PAAS.

PAAS; hoe hoger in de stack – hoe meer restricties.

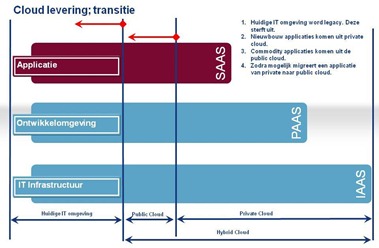

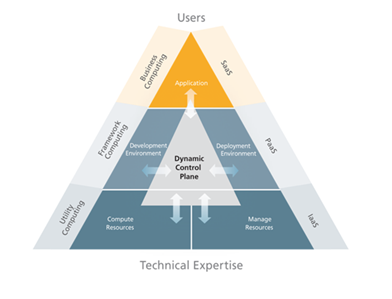

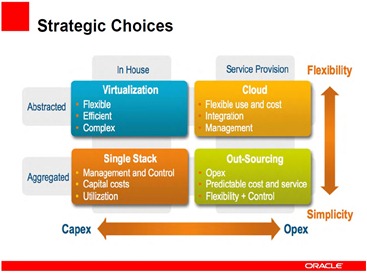

Bij de traditionele IT hebben we zelf de controle over alles inclusief de, zelf bedachte, architectuur die alle lagen in de IT stack aan elkaar bind. Als we gebruik gaan maken van cloud geven we een gedeelte van deze controle uit handen;

Deze stap geeft ons dan een referentie architectuur van de cloud leverancier waar we ons aan moeten houden. Deze commitment geeft ons echter wel alle cloud voordelen, die we zo graag willen hebben. Hoe hoger in de IT stack, hoe meer toegespitst op 1 bepaald doel de omgeving word. IAAS levert o.a. generieke rekenkracht en opslag. PAAS levert een specifieke ontwikkel omgeving (bijvoorbeeld JAVA). SAAS levert een specifieke applicatie (bijvoorbeeld Salesforce CRM). Dit alles geoptimaliseerd naar gebruik, met de bijbehorende voor- en nadelen.

IT appliance =! Cloud

In een poging om mee te komen met het cloud geweld van andere leveranciers rond private cloud, gooit Oracle het over een andere boeg. Ze lanceerde recent de Oracle Exalogic. Het idee hierbij is om PAAS te bieden in je eigen omgeving. In feite hebben ze SUN hardware genomen en daar boven op de Oracle Linux en die aangevuld met Oracle middleware, database en Java (ook uit de SUN stal). Al deze bouw blokken bij elkaar kunnen ze uiteraard maximaal optimaliseren aangezien dit uit de eigen fabriek komt. Dit is een single stack benadering en deze lijkt erg op een IT appliance toepassing.

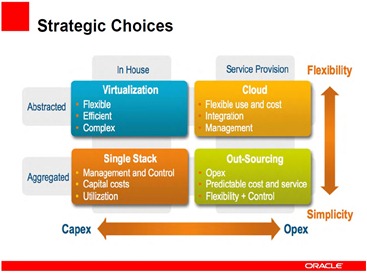

Oracle weet zelf ook wel dat het aanbieden van een IT appliance geen cloud computing is, maar een Single Stack benadering;

Ook zie je hierbij dat je flexibiliteit verliest als je kiest voor een totale geïntegreerde stack oplossing. Nu behoeft deze oplossing geen slechte keuze te zijn als de uitnutting er van voor de organisatie maar optimaal is.

Oracle en andere private cloud leveranciers roepen uiteraard dat hun oplossing schaalbaar is en elastisch. Dat is uiteraard maar ten delen waar. De vraag is bijvoorbeeld in welke eenheden het bouwblok geleverd word. Dit bepaald o.a. de kosten voor de opschaling. Als een bouwblok bijvoorbeeld 100 servers bevat en je hebt er 110 nodig… betekend dat 200 servers… en de bijkomende desinvestering voor de tijd dat deze overige 90 stuks niet gebruikt worden. Ook het afschalen lijkt een uitdaging: komt de leverancier de servers direct weer weg halen uit mijn datacenter, als ik ze niet meer nodig heb ? (echte pay-per-use?!?)

Dit alles lijkt soms opgelost te kunnen worden door lease en huur constructies, maar deze komen altijd met prijs toeslag. Ook geeft deze constructie een uitdaging rond capaciteitsmanagement en de voorspelling van de benodigde capaciteit gedurende de contract looptijd.

Op dit punt zou Microsoft dus wel eens gelijk kunnen hebben dat outsourcing goedkoper is dan een private cloud.

Schaalgrote en innovatie.

Bij alle bovenstaande oplossingen word het al snel duidelijk dat schaal de sleutel is.

Schaal gaat nog een stap verder dan kosten; innovatie is hier ook aangekoppeld. Het collectieve gebruik van public cloud levert meer feedback op en accelereert daar mee de ontwikkeling. De algemene slag kracht van public cloud leveranciers is o.a. hier door ook hoger. Voor de private cloud is het maar zeer de vraag of het opkopen van technologie zoals de huidige IT super-leveranciers nu doen (HP, Oracle, etc..) houdbaar is voor de toekomstige innovatie. Het kopen van een innovatie is een stap, maar het gaande houden van deze ontwikkeling is een hele andere. Dit is waar Gartner recent tegen ageerde;

“Acquiring innovation is one thing, maintaining it is completely different,” said Sondergaard. Integration across an entire stack by one IT provider “is impossible to maintain long term – users will not accept architectural mediocrity,” he added.

Wat dat betreft is er best wat te zeggen voor de route die Cisco, VMware en EMC hebben genomen met hun VBlock oplossing waarbij dit deel van de stack niet onder gebracht is bij 1 leverancier. Ook de route van de Amerikaanse overheid rond apps.gov en OpenStack (NASA) blijkt een valide idee.

Schaal is de sleutel…

De schaal van public cloud is groter dan die van private cloud en dus kosten effectiever. Het neerzetten van een private cloud op IAAS laag geeft meer schaal voordeel dan een PAAS oplossing omdat deze laatste (PAAS) toegespitst is op het leveren van een specifieke dienst en de eerste (IAAS) op een generieke dienst. Hier door zal al snel de schaal van de IAAS omgeving groter zijn en de uitnutting er van beter.

Hoe meer afnemers op het platform, hoe efficiënter de oplossing wordt. Hier mee is public cloud efficiënter dan private cloud en word private IAAS efficiënter dan private PAAS.

Voorlopig nog genoeg stof tot nadenken… met dank aan Microsoft…

Zie ook:

Microsoft offers a refreshing perspective on government clouds

Microsoft Reveals Its Cloud Business Strategy

Private cloud discredited, part 1

Andere mening ? Reageer hier onder of in 140 karakters via twitter @jmwiersma.

Gisteren ging een deel van de Amazon AWS dienst verlening plat. Amazon melde het volgende:

Gisteren ging een deel van de Amazon AWS dienst verlening plat. Amazon melde het volgende: